人工智能是这几年间发展迅速的一项科技,一直都倍受关注,我国社会经济发展的十分迅速,最简单的计算机网络技术已经进入我们千家万户,并且推动着许多行业的飞速发展,人工智能现在已经渐渐地进入我们的生活,他为我们的生活,学习,工作都带来了便利,有报告说在未来的十年,人工智能将完全进入我们的生活,变得无处不在。 人工智能到底是什么?

人工智能(Artificial Intelligence),英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。人工智能亦称智械、机器智能,指由人制造出来的机器所表现出来的智能。通常人工智能是指通过普通计算机程序来呈现人类智能的技术。通过医学、神经科学、机器人学及统计学等的进步,有些预测则认为人类的无数职业也逐渐被人工智能取代。

1、AI定义-人工智能就是通常意义下的人工系统

人工智能的定义可以分为两部分,即“ 人工”和“ 智能”。“人工”比较好理解,争议性也不大。有时我们会要考虑什么是人力所能及制造的,或者人自身的智能程度有没有高到可以创造人工智能的地步,等等。但总的来说,“人工系统”就是通常意义下的人工系统。关于什么是“智能”,就有很多问题了。这涉及到其它诸如 意识(CONSCIOUSNESS)、 自我(SELF)、 思维(MIND)(包括无意识的思维(UNCONSCIOUS_MIND))等等问题。

人唯一了解的智能是人本身的智能,这是普遍认同的观点。但是我们对我们自身智能的理解都非常有限,对构成人的智能的必要元素的了解也很有限,所以就很难定义什么是“人工”制造的“智能”了。因此人工智能的研究往往涉及对人的智能本身的研究。

人工智能是研究使计算机来模拟人的某些思维过程和智能行为(如学习、推理、思考、规划等)的学科,主要包括计算机实现智能的原理、制造类似于人脑智能的计算机,使计算机能实现更高层次的应用。人工智能将涉及到计算机科学、心理学、哲学和语言学等学科。可以说几乎是自然科学和社会科学的所有学科,其范围已远远超出了计算机科学的范畴,人工智能与 思维科学的关系是实践和理论的关系,人工智能是处于思维科学的技术应用层次,是它的一个应用分支。

从思维观点看,人工智能不仅限于逻辑思维,要考虑形象思维、灵感思维才能促进人工智能的突破性的发展,数学常被认为是多种学科的基础科学,数学也进入语言、思维领域,人工智能学科也必须借用数学工具,数学不仅在标准逻辑、 模糊数学等范围发挥作用,数学进入人工智能学科,它们将互相促进而更快地发展。2、研究价值-获得新的发展更有意义

例如繁重的科学和工程计算本来是要人脑来承担的,如今计算机不但能完成这种计算,而且能够比人脑做得更快、更准确,因此当代人已不再把这种计算看作是“需要人类智能才能完成的复杂任务”,可见复杂工作的定义是随着时代的发展和技术的进步而变化的,人工智能这门科学的具体目标也自然随着时代的变化而发展。它一方面不断获得新的进展,另一方面又转向更有意义、更加困难的目标。人工智能目前已成为政、学、研、投、产等各界人士谈论的最热门话题,其重要性已经可以与前三次工业和科技革命相媲美,足见其将对人类社会带来何等重要的影响,今天我们就来回顾一下人工智能过往的发展历程。

1950年,人工智能之父英国人阿兰·图灵一篇里程碑式的论文《机器能思考吗?》为人类带来了一个新学科—人工智能。为了证明机器是否能够思考,他又发明了“图灵测试” (Turing Test)。即当我与对面进行对话时,如果我分辨不出对面是一台机器还是一个人在与我对话,就说明机器具有了人的智能。1956 年“人工智能”首次在达特茅斯会议中被提出,John McCarthy, Marvin Minsky, Allen Newell, Arthur Samuel 以及 Herbert Simon 五人顺势成为当时这一领域的领军人物。紧接着人工智能开始酝酿其第一次浪潮,人工智能实验室在全球各地扎根。在那个人工智能的风口浪尖上,AI 五大领袖们开始对这个领域的发展前景表现出极其的乐观。1973 年,以《莱特希尔报告》的推出为代表,象征着人工智能正式进入寒冬。这篇报告宣称”AI 领域的任何一部分都没有能产出人们当初承诺的有主要影响力进步“。各国政府勒令大规模削减人工智能方面的投入。这之后的十年间,人工智能鲜有被人提起。

到了上世纪九十年代后期,由于计算机计算能力的不断提高,人工智能再次卷土重来。以数据挖掘和商业诊断为主要代表的应用非常成功,使人工智能重回人们的视野。2006年,以 Geoffrey Hinton 为代表的研究人员发现了训练高层神经网络的有效算法。2012年,Geoffrey Hinton团队在ImageNet上首次使用深度学习技术完胜其它团队,让人们意识到深度学习相比于传统机器学习的长处,让深度学习重新回到主流技术舞台。自此之后,随着以图形计算为代表的GPU在计算机视觉训练中替代原来的CPU,大大提升了计算性能,让原来需要几个月才能完成的训练缩短到几天或几个小时,加快了计算机视觉前期训练和推理的迭代周期,带来效率上的成倍提升。百度李彦宏曾说,百度前首席科学家吴恩俊之所以离开谷歌加入百度,就是因为谷歌不让买GPU,他们之前一直使用CPU进行训练。

Geoffrey Hinton在ImageNet 2012上的成功让科学家开始更多的关注模型与算法的创新突破以弥补训练中数据的不足,从而带来算法上的快速迭代,互联网的兴起为计算机训练提供了更多的场景和海量的数据,从而让计算机视觉训练更加全面,准确率也更高。

2016年3月,谷歌AlphoGo 4:1击败韩国围棋冠军李世石就是三者结合的典型代表,让人工智能不再是高高在上的遥不可及,从此进入大众视野,带领人工智能进入又一波高潮。目前人工智能技术已广泛应用于智能驾驶、智慧安防、智慧金融、智慧零售等新的行业形态,并为人们的生活带来很大的便利。

3、历时七年“天机”登Nature封面-

施路平教授团队开发全球首款异构融合芯片

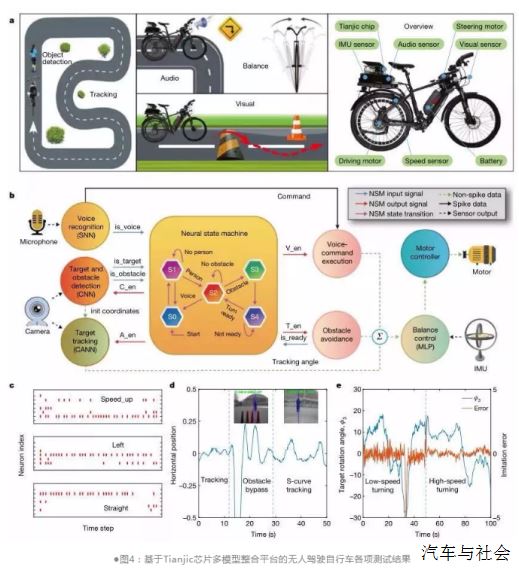

清华大学类脑计算研究所中心,施路平教授团队开发出全球首款异构融合类脑芯片。研究团队还展示了由该芯片驱动的“无人驾驶自行车”,登上最新一期Nature封面。

基于此研究成果的论文“面向人工通用智能的异构天机芯片架构”(Towards artificial general intelligence with hybrid Tianjic chip architecture)作为封面文章登上了8月1日《自然》(Nature)。

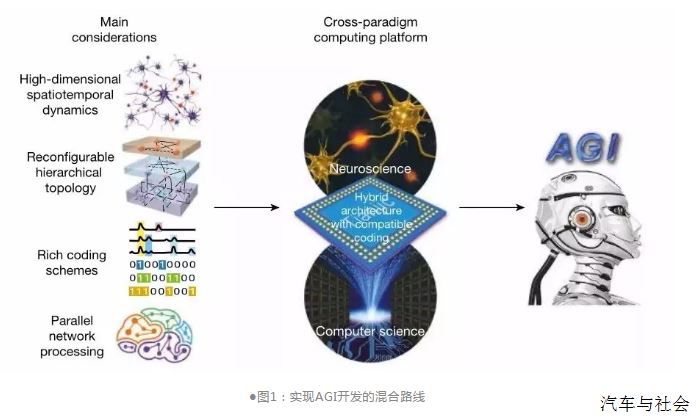

实现了中国在芯片和人工智能两大领域《自然》论文零的突破。在现阶段时代,发展人工通用智能的方式主要有两种:一种是以神经科学为基础,尽量模拟人类大脑;另一种是以计算机科学为导向,让计算机运行机器学习算法。二者各有优缺点,目前将两者融合被公认为最佳解决方案之一。发展一个二者融合的计算平台将是推动融合的一个关键。

新型芯片融合了两条技术路线,这种融合技术有望提升各个系统的能力,推动人工通用智能的研究和发展。这种混合芯片被命名为“天机芯”(Tianjic),有多个高度可重构的功能性核,可以同时支持机器学习算法和现有类脑计算算法。研究人员用一个自动行驶自行车系统验证了这一混合芯片的处理能力。这是一个异构可扩展人工通用智能开发演示平台,利用一块天机芯片,展示了自行车的自平衡、动态感知、目标探测、跟踪、自动避障、过障、语音理解、自主决策等功能。试验中,无人自行车不仅可以识别语音指令、实现自平衡控制,还能对前方行人进行探测和跟踪,并自动避障。

为什么选择使用自行车作为切入点,是因为自行车是为我们芯片服务的。当时我们经过了反复的深入讨论,确定要开发一款什么样的应用平台来展示我们这样一个异构融合新的功能,这是一件不容易的事情。我们有四点考量:第一,我们希望这是一个有点类似大脑的一个多模态系统,而不是像现在AI的一些做算法,只做单一应用。我们希望这是一个覆盖感知决策和执行的完整的链路,这样才能够给我们异构融合的多种模型提供支撑,所以这是与单一模型不同的。第二,我们希望这个也是能够与真实环境交互的,而不是说在机房里面做一下实验或者在电脑里做一套仿真。我们希望它能够是一个真实环境交互。第三,我们希望这个系统它最好是对我们的处理芯片是有功耗和实时性要求的,这样才能够体现我们专用芯片的优势。第四,是因为我们要通过做反复的实验,我们希望这个系统是可控的、可扩展的。通过考量上述几点,我们最终选择了无人自行车平台,让它有语音识别的功能、有目标探测追踪的功能,可以运动控制、避障、自主决策。所以它看起来虽然很小,但实际上是一个五脏俱全的小型的类脑计算平台。施路平教授表示,这只是非常初步的一个研究,但这项研究或能为面向人工通用智能计算平台的进一步发展起到促进作用。

4、详细解读这一突破性研究-

“天机芯”是支持计算机科学和类脑计算融合的AGI之路

一般认为,实现通用人工智能(AGI)有两条路:分别为计算机科学导向和神经科学导向。由于这两条路的思路、理念和实现方案存在根本差异,分别依赖于不同开发平台,彼此互不兼容,这给AGI技术的开发造成很大阻碍。目前迫切需要一个同时支持两种方法的通用平台。施路平团队开发的“天机芯”(Tianjic芯片)就做到了这一点,可以为AGI技术提供一个混合协同的开发平台。

Tianjic芯片采用众核架构、可重构功能核模块和混合编码方案的类数据流控制模式,不仅可以适应基于计算机科学的机器学习算法,还可以轻松实现受大脑原理启发的神经计算模型和多种编码方案。

仅用一个芯片,就可以在无人驾驶自行车系统中同时处理多种算法和模型,实现实时目标检测、跟踪、语音控制、避障和平衡控制。这一研究预计可以为通用性更高的硬件平台发展开拓新的道路,促进AGI技术的开发。鉴于目前机器学习和神经科学的进步,AGI系统至少应具有以下特征:1.能够支持在神经网络中进行丰富的空间、时间和时空关系的表达。2.支持分层、多粒度和多域网络拓扑架构,不限于某一专门的网络结构。3.支持各种模型,算法和编码方案。4.支持多个专用神经网络的交织合作,这些神经网络可能是为并行处理不同任务而设计的。5.这些特征需要在一个通用化的平台中高效地运行,即能够在统一框架中实现对主流的人工神经网络(ANN)以及受神经科学启发的模型和算法的支持。

为了支持这些功能,团队开发了一种跨范式计算平台,可以适应面向计算机科学和神经科学的神经网络,兼容各种神经模型和算法,尤其是基于生物学的(如脉冲神经网络,即SNN)要素。

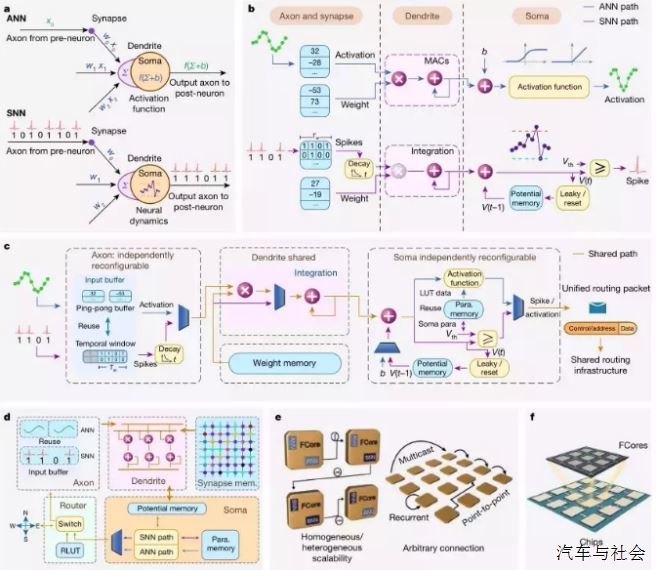

通常,ANN和SNN在信息表示、计算原理和记忆组织方面具有不同的建模方式。二者最大的差异是,ANN以精确的多位值来处理信息,而SNN使用二进制脉冲序列。ANN神经元和SNN神经元之间的实现比较。另一方面,ANN和SNN神经元之间也存在一些相似之处,这就为模型间的融合留下了空间。通过对ANN和SNN的神经网络模型进行详细比较,将计算模型解析并对应到相关的神经元功能模块上 - 即轴突、突触、树突和胞体,从而构建一个跨范式的统一神经元方案。团队设计了同时适用两种方案的突触和树突,而轴突和体细胞通过独立重构来改变功能。

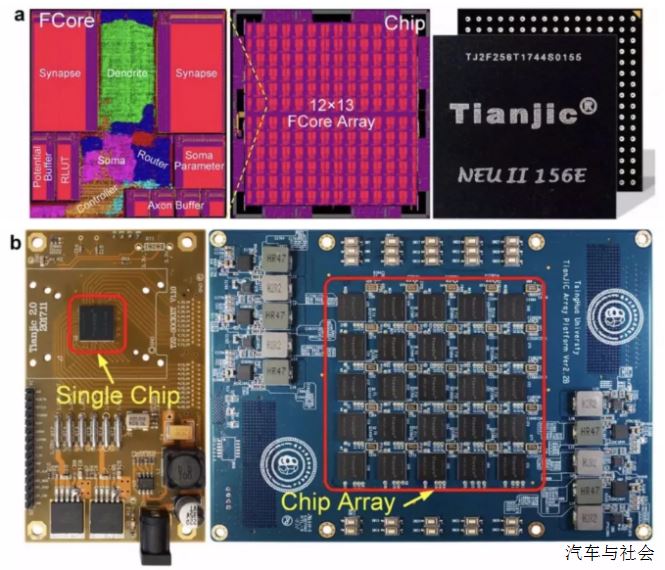

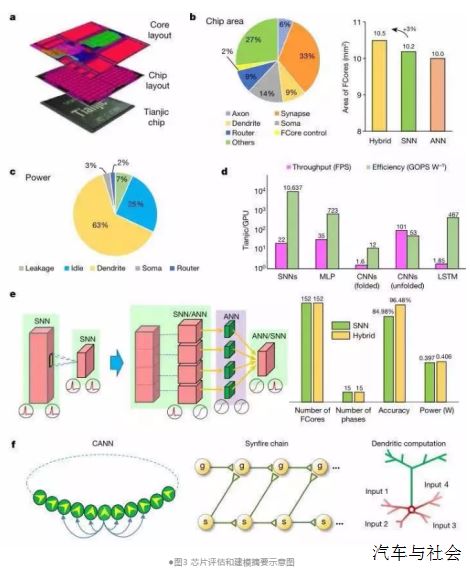

(图2 Tianjic芯片设计示意图)

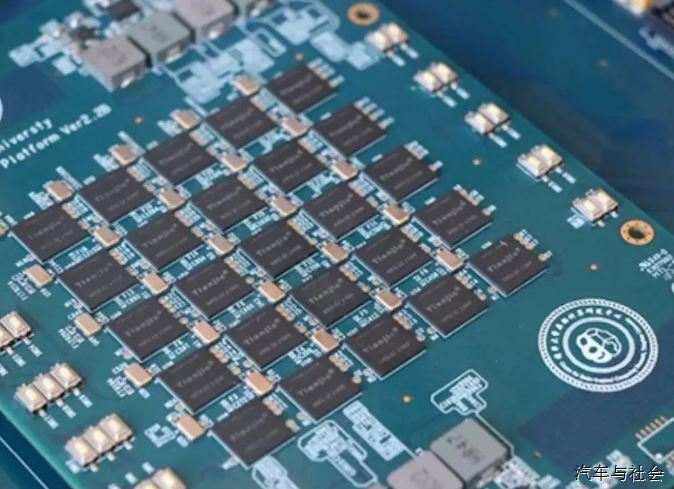

图2d是一个完整的单功能核(FCore)示意图,包括轴突、突触、树突、胞体和路由部分。为了实现深度融合,几乎整个FCore都可以重新配置,以便在不同模式下实现高利用率。FCore能够涵盖大多数ANN和SNN使用的线性积分和非线性变换操作。该芯片上的FCores以二维2D网格方式排列,如图2e和2f所示。

Tianjic芯片和其后端布局图如图3a所示。芯片由156个FCore组成,包含大约40000个神经元和1000万个突触。Tianjic芯片采用28纳米半导体工艺制造,面积为3.8×3.8平方毫米。每个独立模块占用的芯片面积,包括轴突,电流,信号,路由器,控制器和其他芯片开销,如图3b所示。由于资源可以重复使用,用以兼容SNN和ANN模式的区域仅占总面积的3%左右。FCore的功耗分解如图3c所示。

Tianjic能够支持多种神经网络模型,包括基于神经科学的网络(如SNN,以及基于生物学启发的神经网络)和基于计算机科学的网络(如MLP,CNN和RNN等)。图3d所示为在Tianjic芯片上测试不同网络模型与通用处理单元的测试结果。如图3e所示,具有树突中继的混合神经网络可突破传统神经形态芯片Fan in/fan out的限制,避免SNN网络的精度损失(+11.5%)。采用这种混合模式增加的额外开销小到可以忽略不计,因为Tianjic可以自然地在FCore中实现异构转换。使用Tianjic还可以探索更具生物学意义的认知模型(如图3f所示)。为了证明构建类脑跨范式智能系统的可行性,团队利用无人驾驶自行车发展了一个异构可扩展人工通用智能开发展示平台,在一块Tianjic芯片内并行部署并同时运行 多个专用网络。要实现这些任务,需要克服三个主要挑战:

首先,在室外自然环境中成功检测并平滑跟踪移动目标、跨越减速带,并在必要时自动避开障碍物。第二,需实时响应平衡控制、语音命令和视觉感知产生实时电机控制信号,以保持自行车在正确的方向上运动。第三,实现多种信息的集成处理和快速决策。

实验中的自行车配备了多种算法和模型,能够执行实时物体检测、跟踪,语音命令识别、加速、减速、躲避障碍、控制平衡和决策等任务(图4a)。为了完成这些任务,团队开发了几个神经网络,包括用于图像处理和物体检测的CNN,用于人类目标跟踪的CANN,用于语音命令识别的SNN,用于姿态平衡和方向控制的MLP,还有用于决策控制的混合网络。由于芯片的分散式架构和任意路由拓扑,Tianjic芯片平台可以实现所有神经网络模型的并行化运行,并实现多个模型之间的无缝通信,使自行车能够顺利完成这些任务。图4c显示响应不同语音命令的输出信号。图4d显示自行车在跟踪、避障和和“S形”曲线行进时的输出控制信号。图4e为基于物理量度的不同速度下的车辆姿态和转向控制的学习情况。 Tianjic芯片可以同时支持基于计算机科学的机器学习算法和基于神经科学的生物学模型,可以自由地集成各种神经网络和混合编码方案,实现多网络之间的无缝通信,包括SNN和ANN。总而言之,本文介绍了一种新颖的类脑计算的芯片架构,通过将交叉范式模型和算法集成到一个平台上来实现灵活性和扩展性。希望这一研究成果能够加速AGI的发展,推动新的实际应用的发展。